近年来,国产深度学习模型DeepSeek声名鹊起,备受瞩目。然而,正因如此,DeepSeek的服务器频繁遭遇反应迟缓甚至宕机的状况,这不禁让人联想到两年多前ChatGPT所面临的类似困境。幸运的是,DeepSeek是一个开源模型,这为我们提供了极大的便利。我们可以通过本地部署的方式,在自己的终端设备上随时随地使用它。接下来,我将为大家详细介绍具体的操作步骤。

一、DeepSeek本地部署

首先我们需要安装Ollama,它可以在本地运行和管理大模型。

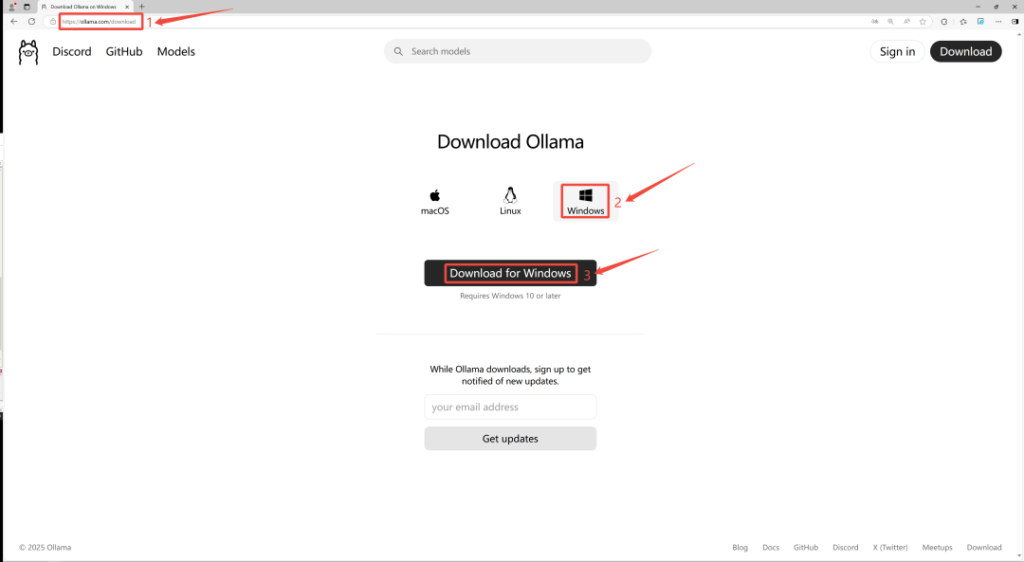

到Ollama官网 https://ollama.com,点击下载,然后选择适合自己系统的版本,这里选择Windows:

安装完成后,win+R打开,然后输入cmd进入命令行界面

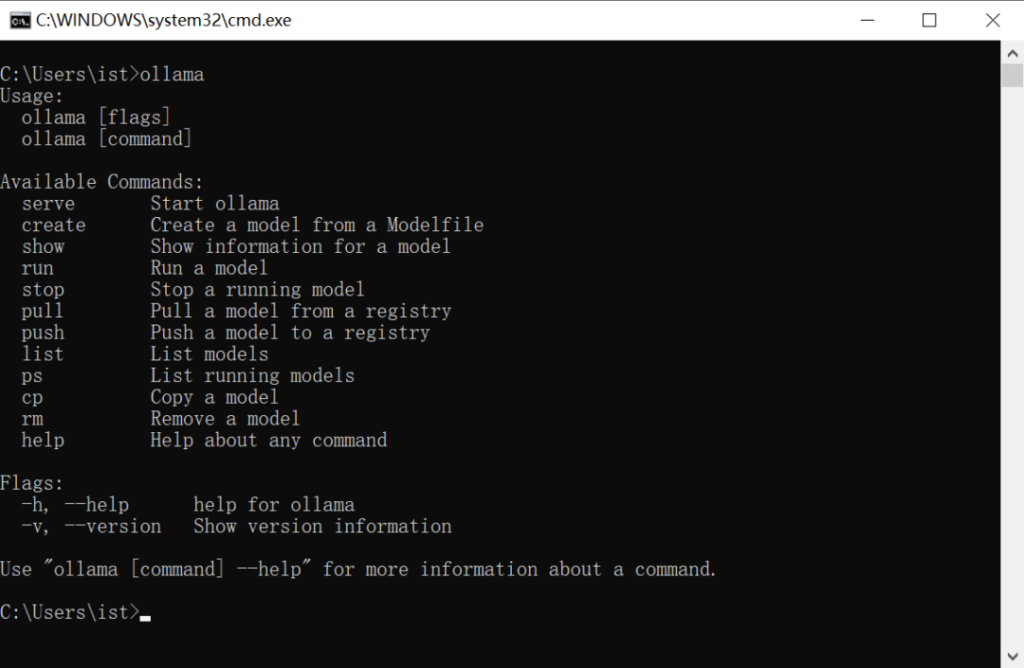

然后输入该命令:

ollama如果屏幕上出现以下提示信息,那么恭喜你,Ollama 已经成功安装。

![图片[4]-DeepSeek本地部署+WebUI可视化,小白专业教程~建议收藏!-星海云库-云上资源](https://i-blog.csdnimg.cn/img_convert/4fcdeb09ee4a3891a7a84b2e8d9a48d1.png)

2、部署 DeepSeek R1 模型

访问 Ollama 官网找到「DeepSeek R1」

在模型详情页面,根据我们计算机的显存容量选择合适的模型版本

#1.5b模型--适合4G显存及以下

ollama run deepseek-r1:1.5b#7b模型--适合8G显存

ollama run deepseek-r1:7b#8b模型--适合8G-12G显存

ollama run deepseek-r1:8b#14b模型--适合8G-12G显存

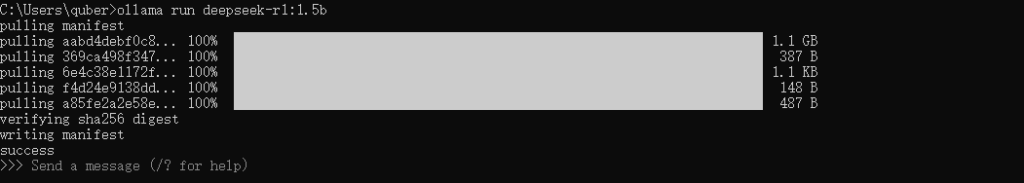

ollama run deepseek-r1:14b将此下载命令复制并粘贴到命令行中执行开始下载:

![图片[7]-DeepSeek本地部署+WebUI可视化,小白专业教程~建议收藏!-星海云库-云上资源](https://i-blog.csdnimg.cn/img_convert/03a4e6d879d52a8d745d3a6b9cb0201b.png)

温馨提示:下载过程中,最开始下载速度可能要快一些,下载到后面可能就几百KB了,此时我们可以按Ctrl+C停止下载,然后再重新复制命令执行下载,此时的下载速度又恢复到了几MB了(此操作可能会遇到重新下载的情况,但是几率很小),如此往复操作即可,如下图所示:

如出现如下图所示的效果就代表下载完成了:

8.1、🎨Web ui可视化

Chrome插件-Page Assist

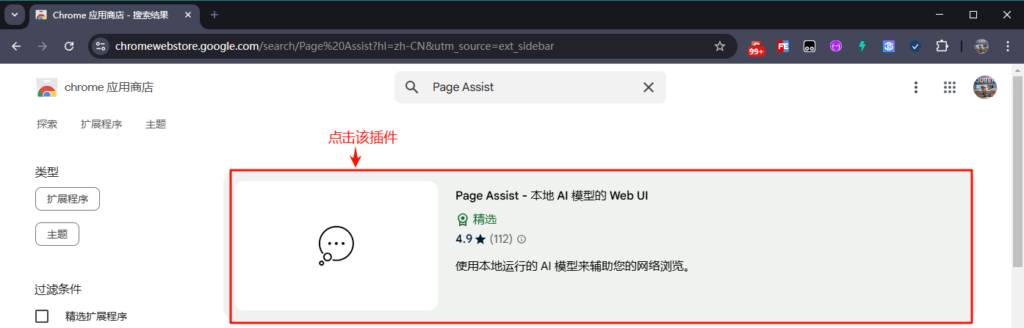

首先我们通过谷歌浏览器官方插件地址搜索Page Assist,点击Page Assist - 本地 AI 模型的 Web UI,如下图所示:

然后添加到Chrome:

安装完成后,我们可以将该插件固定(钉)到浏览器顶部,方便使用,如下图所示:

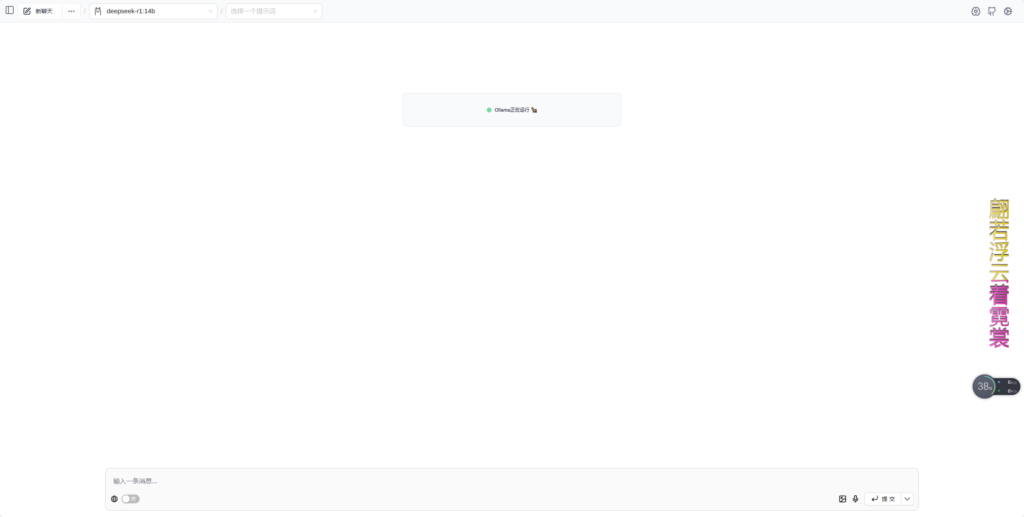

随后我们点击该插件,就会出现如下图所示的界面:

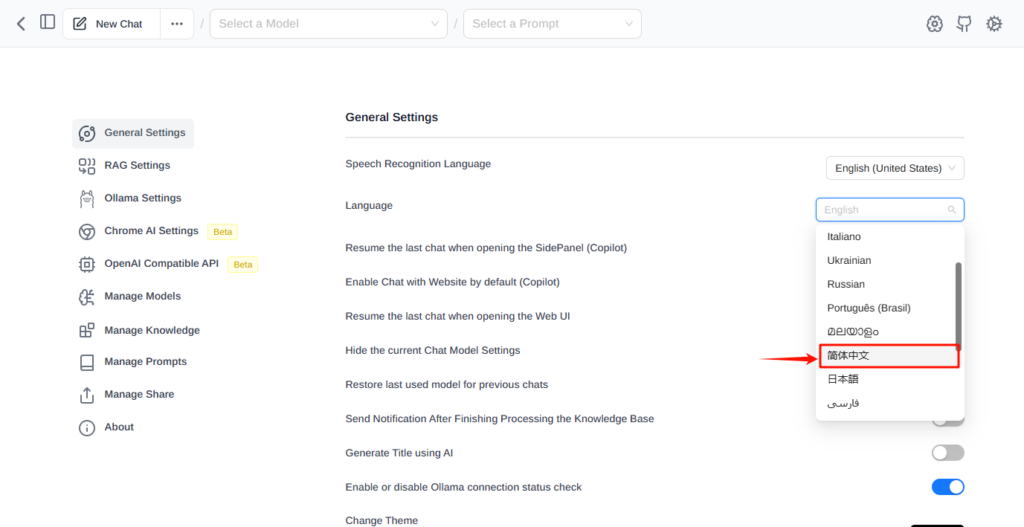

在界面中出现了Unable to connect to Ollama的提示,是因为我们安装的Ollama没有启动,此时我们只需要启动Ollama软件即可,设置中文:点击界面右上角的Settings按钮,将语言设置为简体中文,如下图所示:

设置完成后返回主界面,此时就是中文界面了。

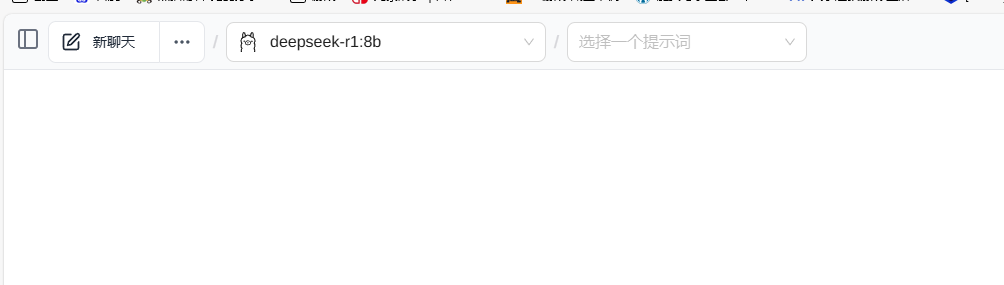

选择模型:点击主界面中的第一个下拉框,选择我们刚才下载的模型deepseek-r1:8b,如下图所示:

到此,配置就完成了。

对话演示:接下来我们就可以愉快的对话了,效果如下图所示:

暂无评论内容